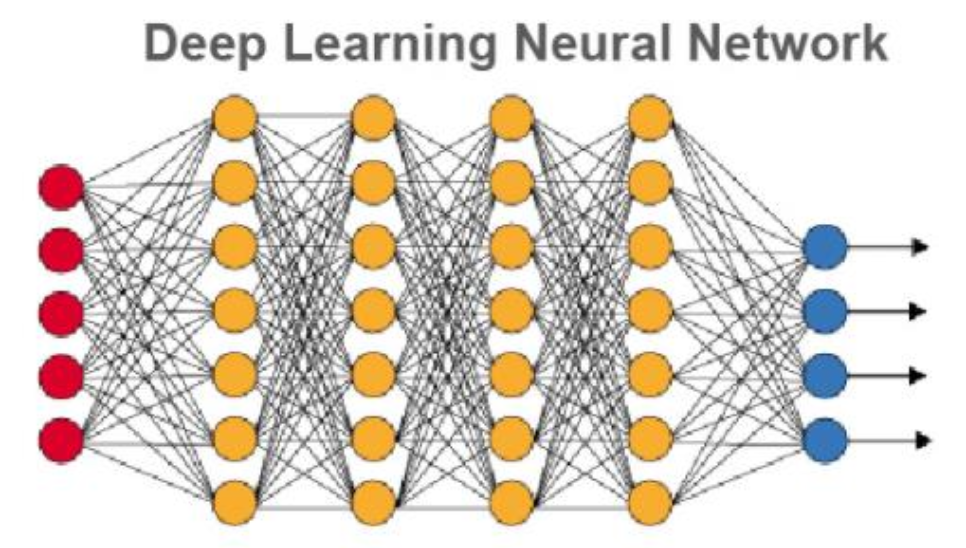

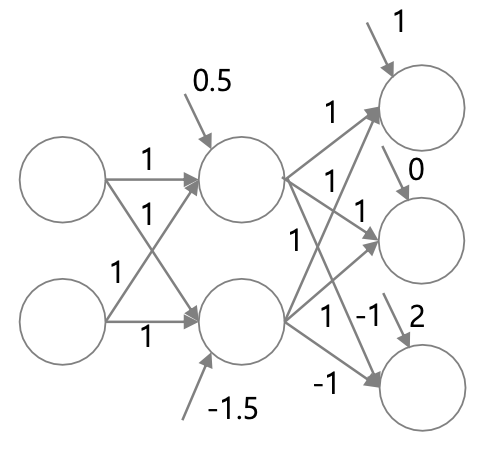

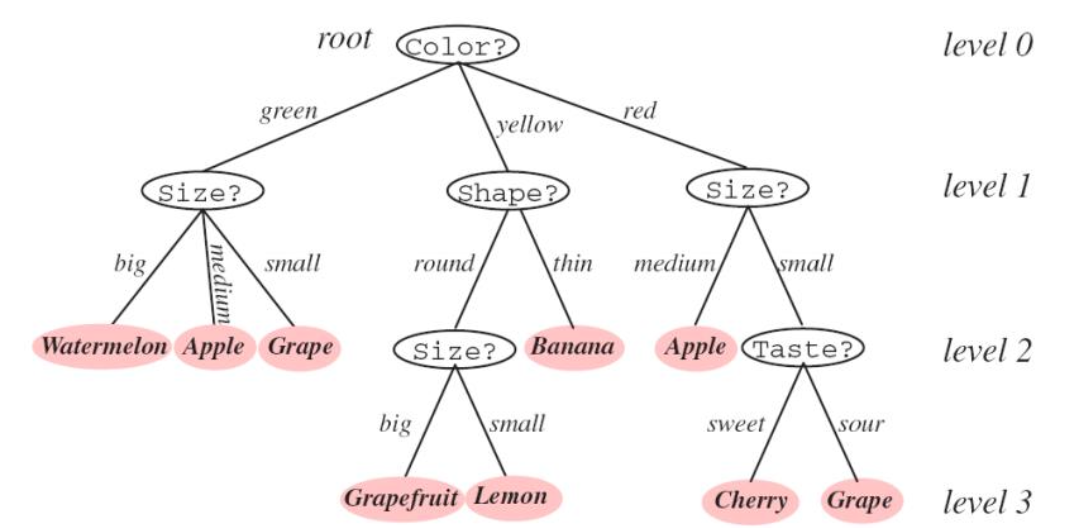

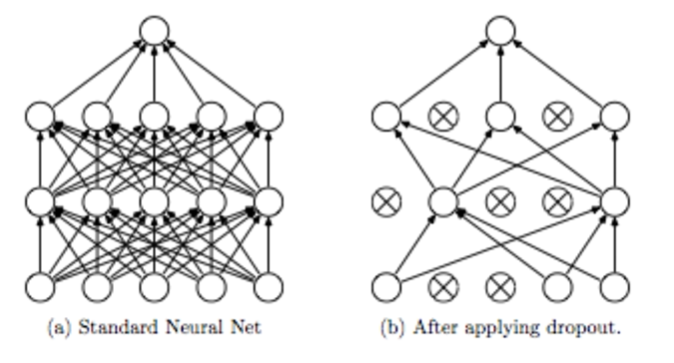

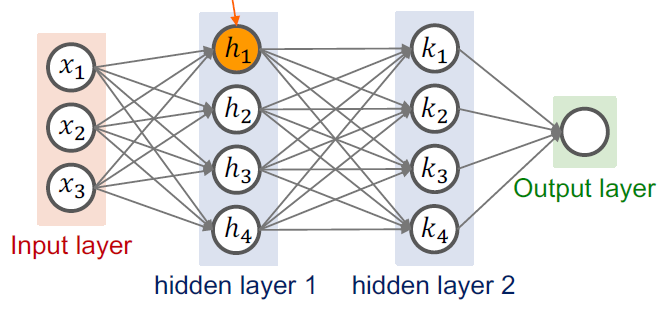

Deep Neural networks (DNN) Neural Network에 Deep을 붙인 이유는 hidden layer의 수를 많이 두었기 때문이다. hidden layer를 많이 둬 더 많은 최적화 업데이트 대상이 되는 파라미터를 두고 더 복잡한 형태로 input과의 관계를 모델링하는 것이 목적이다. 따라서 깊은 네트워크의 구조를 가져서 DNN이라고 부르며 DNN 기반의 어떤 ML 작업을 Deep Learning라고 한다. Architecture design 여러 개의 hidden layer를 두는 이유는 capacity를 높이기 위함이다. 즉, input과 output의 관계를 잘 나타낼 수 있다. Universal approximation theorem은 하나의 hidden layer와 여러 개..