Dropout과 Ensemble

이전에 우리는 Overfitting라는 것을 학습하였다.

overfitting이란 학습 데이터에 대해 100%의 정확도를 내어

오히려 test data set에 대해 낮은 정확도를 보이는 경우를 말한다.

우리는 이러한 overfitting 문제를 해결하기 위해

regularization이라는 것을 학습하였다.

이해하기 쉽기 이야기 하자면,

꼬불꼬불하고 복잡하게 그어진 그래프를

일부 weight를 없앰으로써 평탄하게 만들어주는 것이다.

더 자세한 내용은 아래의 링크를 참고하기 바란다.

https://coding-saving-012.tistory.com/90

[ML/머신러닝] Learning Rate, Data Preprocessing, Overfiting

Learning Rate 우리는 Gradient Desent(경사하강법)을 통해 결과값과 기대값의 오차를 줄였다. cost function은 위와 같이 정의했었는데 이때 α를 Learining rate(학습률)이라고 하였다. 학습률은 기울기를 이동

coding-saving-012.tistory.com

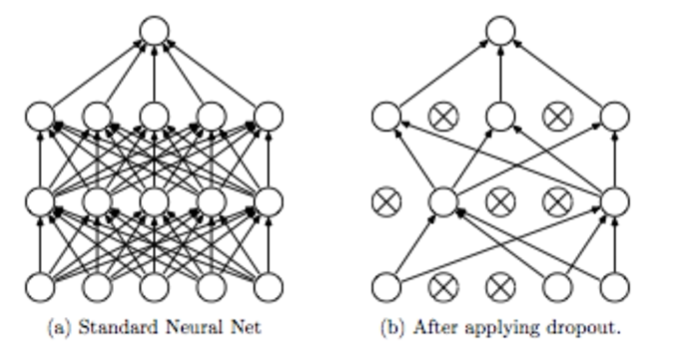

Dropout은 랜덤한 일부 노드를 끊어 없애는 것을 말한다.

따라서 해당 단계에서 필요없는 부분이 존재하는 경우

해당 부분을 없앰으로써 더욱 나은 정확도를 보일 수 있기 때문이다.

Dropout은 랜덤한 노드만을 없애면 되므로 구현도 쉽다.

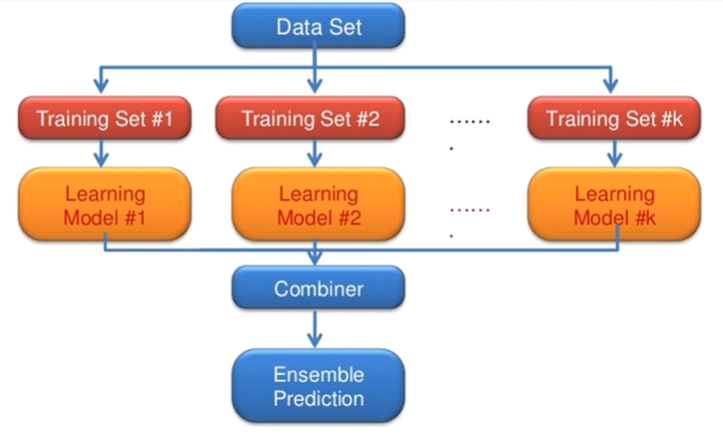

Ensemble은 학습 데이터와 기계가 많은 경우 사용할 수 있다.

각각의 학습 데이터에 대해 서로 다른 모델을 대입하여 학습시킨다.

학습된 결과를 합쳐 새로운 예측 결과를 만들어내는 것을 말한다.

최소 2%에서 많게는 5%까지의 성능이 높아진다.

Network 쌓아보자

네트워크 모듈은 레고처럼 다양하게 쌓을 수 있다.

레이어를 몇 개 건너 뛰어도 되고,

레이어를 여러 개로 나뉘어 가고 되고(split),

합쳐도 되는(merge) 등 여러 가지 방법이 존재한다.

또한 Recurrent Network와 같은 RNN은 옆으로도 레이어가 퍼진다.

'Computer Science > 기계학습 (Machine Learning)' 카테고리의 다른 글

| [기계학습/ML] Introduction to ML (2) | 2023.10.23 |

|---|---|

| [머신러닝/ML] ConvNet (0) | 2023.07.26 |

| [머신러닝/ML] ReLU와 Weight 초기화 (0) | 2023.07.26 |

| [머신러닝/ML] XOR연산 딥러닝으로 풀기 (0) | 2023.07.21 |

| [머신러닝/ML] 딥러닝의 기본 개념 (0) | 2023.07.20 |